Los chatbots de inteligencia artificial están presentes en más lugares de los que imaginas. Aparecen cuando consultas tu banco por internet, cuando navegas tiendas online o cuando buscas ayuda en sitios web.

Estos asistentes digitales pueden mantener conversaciones que parecen humanas, responder preguntas complejas y ayudarte con tareas difíciles. A diferencia de los robots antiguos que solo ofrecían opciones numeradas, los actuales entienden lo que dices y responden de forma natural.

La tecnología detrás de estos sistemas utiliza modelos entrenados con millones de textos. Así aprenden cómo se comunican las personas y pueden imitar esos patrones. Esto les permite escribir correos, explicar conceptos difíciles y resolver problemas técnicos. Por eso muchos usuarios confían en ellos para obtener información rápida y aparentemente confiable.

Sin embargo, algo preocupante está ocurriendo. Los usuarios recurren cada vez más a estos chatbots de IA para verificar si la información que ven en redes sociales es verdadera. Preguntas como “¿Es esto cierto?” dirigidas a asistentes como Grok, ChatGPT y Gemini son ahora comunes en plataformas como X y otras redes sociales.

El problema es que estos sistemas frecuentemente entregan respuestas llenas de errores e información falsa. Mientras las empresas tecnológicas reducen sus equipos de verificadores humanos, las personas depositan más confianza en herramientas que pueden ser menos confiables que las fuentes originales.

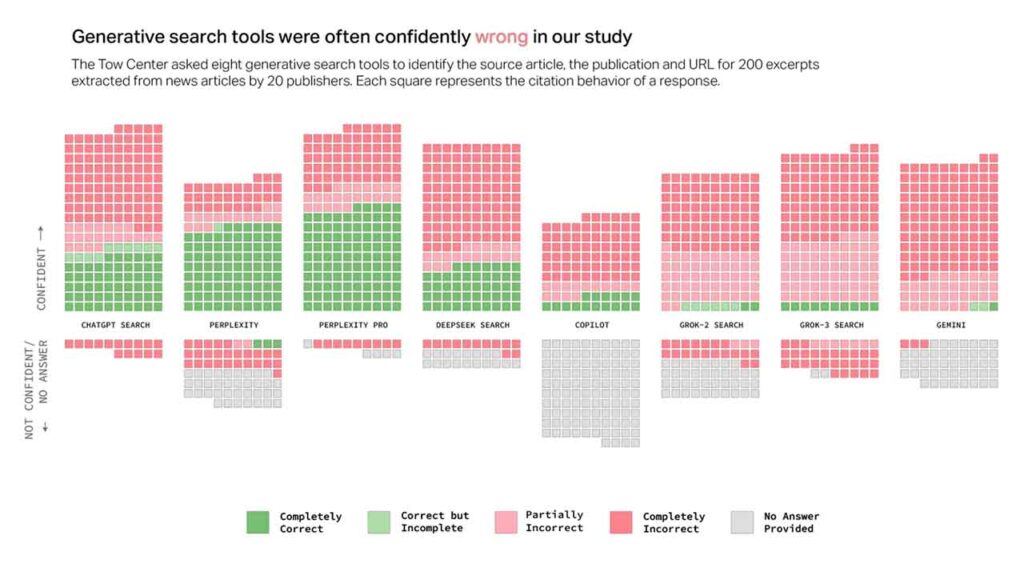

Las investigaciones recientes del Centro Tow para Periodismo Digital revelan datos alarmantes sobre estos sistemas. Los expertos probaron ocho herramientas de búsqueda con inteligencia artificial y encontraron que los chatbots eran malos para admitir cuando no sabían algo.

En lugar de decir “no lo sé”, preferían dar respuestas incorrectas o inventar información.

El problema es que presentan información incorrecta con total seguridad, sin usar palabras como “parece” o “podría ser”.

Esta confianza falsa hace que los errores sean más peligrosos. Los usuarios reciben información incorrecta presentada como hechos verificados. El Centro Tow encontró que estos sistemas “amplifican problemas de sesgo y proporcionan respuestas tóxicas que pueden pasar desapercibidas para usuarios comunes”.

La situación afecta tanto a quienes producen noticias como a quienes las consumen. Los editores ven cómo su contenido es malinterpretado o atribuido incorrectamente. Muchas empresas de IA no muestran interés en trabajar con medios de comunicación. Incluso cuando existen acuerdos comerciales, las citas precisas y el respeto por las preferencias editoriales siguen siendo problemas.

Los editores tienen pocas opciones para controlar cómo aparece su información en las respuestas de los chatbots de IA. Sus artículos pueden ser distorsionados, mal citados o utilizados sin permiso. Esto amenaza tanto la integridad informativa como los ingresos de los medios de comunicación.

¿Quieres saber más? Únete a los canales oficiales de Facialix:

Los expertos coinciden en que estos chatbots de inteligencia artificial no pueden reemplazar la verificación humana de hechos. La verificación efectiva requiere análisis crítico, evaluación de fuentes múltiples y comprensión del contexto que estos sistemas aún no poseen.

Mientras estos sistemas continúan evolucionando, los usuarios deben mantener un pensamiento crítico. Es importante verificar información importante a través de fuentes primarias confiables y no depender únicamente de asistentes automatizados