La inteligencia artificial ha crecido mucho, pero tiene un problema grande: proteger la información personal. Los modelos de lenguaje que aprenden de millones de páginas web pueden recordar y compartir datos privados sin querer. Esto crea riesgos serios para las empresas y las personas que los usan.

Este problema ha frenado el uso de IA en sectores como la medicina, los bancos y el gobierno, donde cuidar la información confidencial es muy importante. Las empresas necesitan sistemas que funcionen bien pero que no pongan en peligro los datos de sus clientes.

Google AI Research y DeepMind acaban de lanzar VaultGemma, un modelo de lenguaje de código abierto que cambia las reglas del juego. Con 1 billón de parámetros, este sistema es el más grande de su tipo entrenado completamente con privacidad diferencial, una técnica matemática que protege los datos personales.

Jeff Dean, Científico Jefe de Google, anunció este avance que aborda los ataques de memorización en modelos de IA. Estos ataques permiten extraer información sensible de sistemas entrenados con datos masivos de internet. VaultGemma demuestra que se puede crear un modelo potente manteniendo garantías rigurosas de privacidad, algo que antes parecía imposible.

Cómo Funciona la Tecnología de VaultGemma

VaultGemma usa una técnica llamada DP-SGD (Differentially Private Stochastic Gradient Descent) que añade ruido controlado durante el entrenamiento. Esta técnica logra una garantía formal de privacidad de (ε ≤ 2.0, δ ≤ 1.1e-10) a nivel de secuencia, números que los expertos consideran muy seguros.

El modelo se entrenó con el mismo conjunto de datos de 13 billones de tokens que se usó para crear Gemma 2. Estos datos incluyen principalmente texto en inglés de páginas web, código de programación y artículos científicos. El entrenamiento se realizó en un clúster de 2048 chips TPUv6e, lo que requirió una inversión considerable en recursos computacionales.

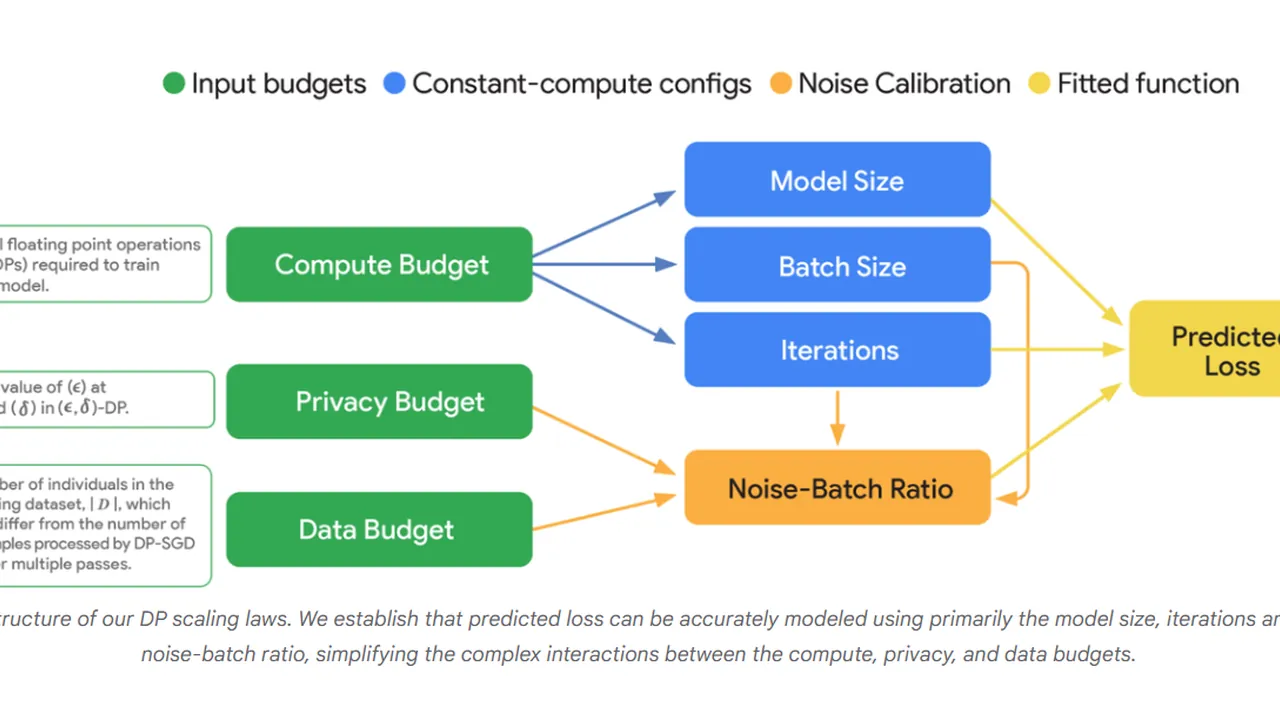

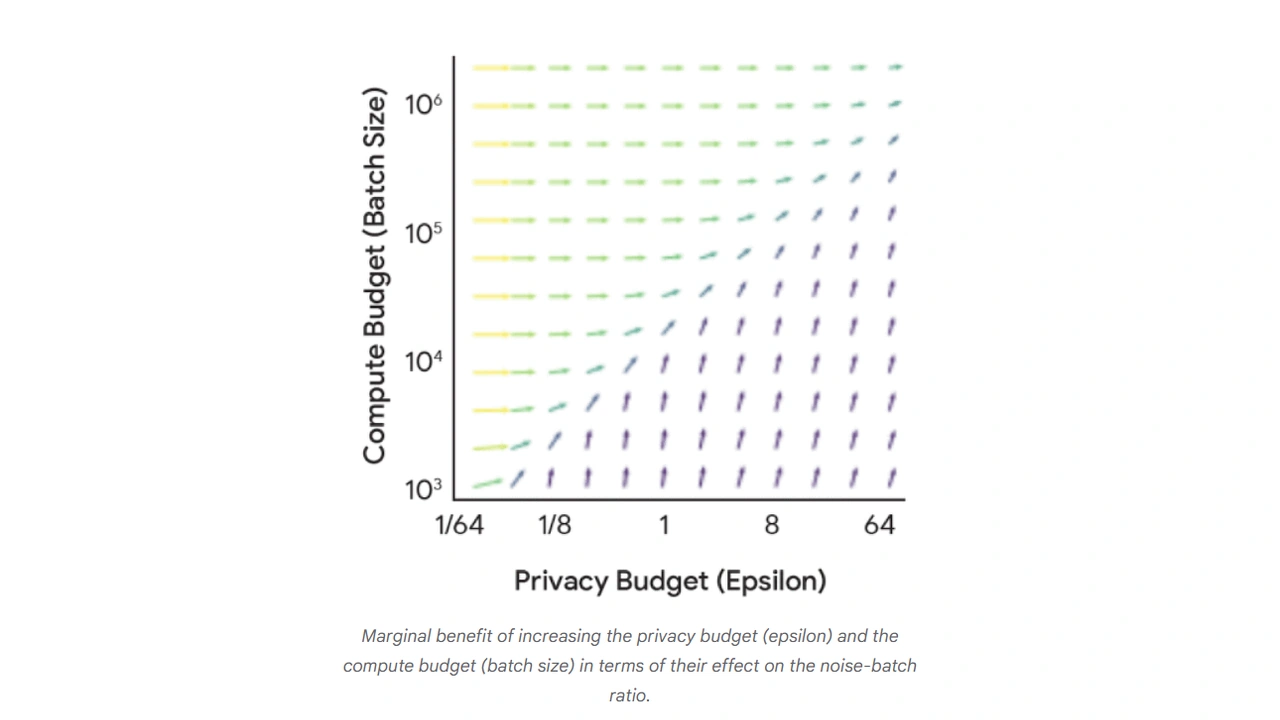

Los investigadores de Google crearon nuevas leyes de escalamiento específicas para modelos con privacidad diferencial. Estas leyes ayudan a entender mejor cómo equilibrar tres factores clave: el poder de cómputo necesario, el nivel de privacidad y la utilidad del modelo final.

Rendimiento y Disponibilidad del Modelo

VaultGemma no muestra señales de memorizar datos de entrenamiento, pero su desempeño es menor comparado con modelos tradicionales. En pruebas académicas estándar, obtiene puntuaciones similares a modelos creados hace cinco años aproximadamente. Por ejemplo, alcanza 26.45 puntos en ARC-C mientras que Gemma-3 1B obtiene 38.31 puntos.

Esta diferencia en rendimiento es el precio que se paga por la privacidad. Sin embargo, Google considera que este intercambio vale la pena para aplicaciones donde proteger datos es más importante que obtener el máximo rendimiento posible.

Google ha liberado los pesos del modelo en Hugging Face y Kaggle de forma gratuita, junto con documentación técnica completa. Esta decisión busca acelerar la investigación en IA privada, dando a otros científicos las herramientas necesarias para continuar mejorando esta tecnología.

El lanzamiento de VaultGemma coloca a Google como líder en el desarrollo de IA que respeta la privacidad. Esta tecnología llega en un momento crucial, cuando los gobiernos aumentan las regulaciones sobre protección de datos y las empresas buscan alternativas seguras para usar inteligencia artificial.

El trabajo demuestra que es posible entrenar modelos grandes manteniendo garantías matemáticas estrictas de privacidad sin volverlos inútiles para aplicaciones reales.