La inteligencia artificial se ha convertido en una parte clave de nuestras vidas, pero su creciente vulnerabilidad plantea un peligro inminente.

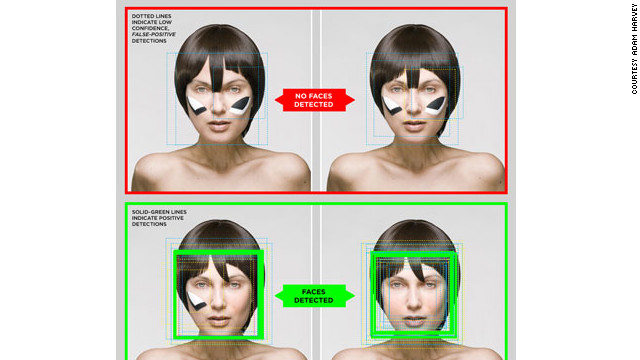

¿Te imaginas un futuro donde los autos autónomos ignoren las señales de alto, los diagnósticos médicos basados en IA sean erróneos o los sistemas de seguridad automatizados dejen pasar a las personas equivocadas?

El riesgo de ataques a los sistemas de IA es real y sus consecuencias pueden ser caóticas.

Ante esta amenaza, los expertos están uniendo fuerzas en el proyecto GARD de DARPA para garantizar la robustez de la IA contra el engaño.

Este ambicioso proyecto busca desarrollar algoritmos y herramientas que protejan los sistemas de IA de manipulaciones y ataques.

Desde adversarios que pueden engañar a algoritmos de aprendizaje profundo hasta objetos 3D que confunden a redes neuronales, se están explorando diversas técnicas para fortalecer la seguridad de la IA.

La importancia de esta iniciativa radica en la creciente dependencia de la IA en sectores críticos como ciudades inteligentes, redes eléctricas y atención médica. A medida que la IA se vuelve más omnipresente, también aumenta el riesgo de ataques.

La colaboración entre DARPA y empresas tecnológicas líderes como IBM y Google garantiza el desarrollo de defensas sólidas y herramientas de evaluación para proteger los modelos de IA actuales y futuros.

La seguridad de la IA es crucial para evitar el caos en nuestras vidas.

Si bien la mayoría de nosotros utiliza la IA en aplicaciones no críticas, como recomendaciones de películas en Netflix, el verdadero desafío está en proteger sistemas como los automóviles autónomos. GARD está trabajando arduamente para anticipar los futuros desafíos de seguridad y garantizar que la IA sea resistente a cualquier forma de ataque.

El futuro está en juego y los expertos se están movilizando para proteger nuestra confianza en la inteligencia artificial.

El proyecto GARD está liderando esta iniciativa con el objetivo de construir un escudo infranqueable para la IA antes de que sea demasiado tarde.

¿Quieres saber más? Únete a los canales oficiales de Facialix: