Usas la inteligencia artificial a diario para escribir correos, resumir documentos o crear imágenes para presentaciones. Mientras disfrutas de estas tecnologías, la seguridad de tus datos cuando interactúas con estos sistemas es cada vez más importante. La seguridad en IA ya no es solo tema para expertos, ahora te afecta directamente.

Cada consulta que escribes, cada imagen que generas y cada petición que haces deja un rastro digital que podría estar más expuesto de lo que piensas. Los modelos de IA procesan enormes cantidades de información personal, y las recientes filtraciones de datos en plataformas populares muestran que ningún sistema es totalmente seguro. Tus datos podrían estar siendo usados por algoritmos sin que lo sepas.

Un estudio reciente de la Universidad de Stanford ha encontrado fallos de seguridad en varias APIs de modelos de lenguaje (LLM). El problema está en una técnica llamada “almacenamiento en caché de prompts”, que usan los proveedores de IA para responder más rápido.

Para entender el problema, piensa que envías una pregunta a ChatGPT o Claude. Para funcionar más rápido, estos sistemas guardan las consultas frecuentes para responder al instante cuando aparecen preguntas parecidas. El problema surge cuando estas memorias temporales se comparten entre usuarios diferentes.

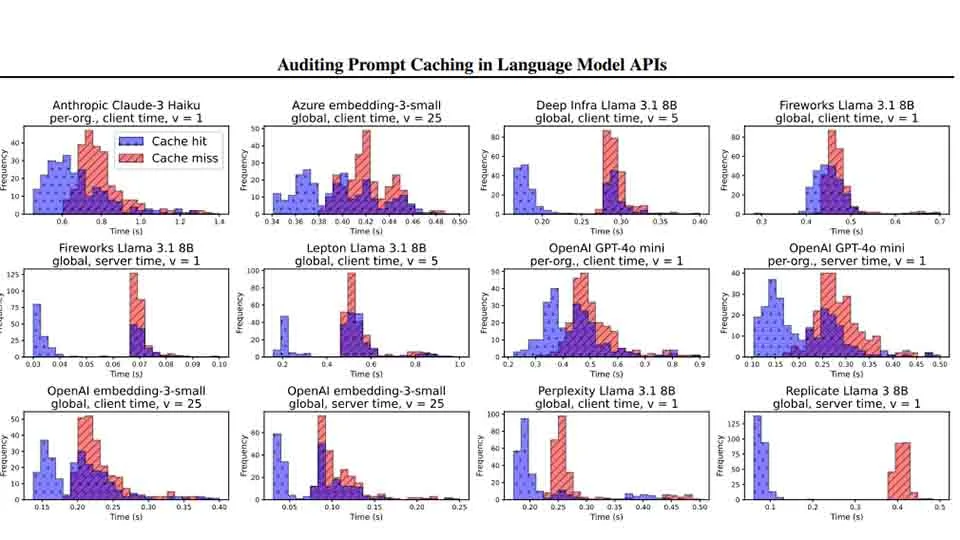

Los investigadores descubrieron que 8 de 17 proveedores de APIs usan esta técnica, y lo más preocupante: 7 de ellos comparten estas memorias entre todos los usuarios del mundo.

La auditoría realizada por el equipo de Stanford identificó comportamiento de almacenamiento en caché en:

- OpenAI

- Anthropic

- Azure

- Deep Infra

- Fireworks

- Lepton

- Perplexity

- Replicate

¿Por qué te debería importar?

Usando un ataque basado en medir tiempos, un atacante podría saber si alguien más ha enviado recientemente una consulta similar a la suya simplemente midiendo cuánto tarda la respuesta. Si la respuesta llega muy rápido (unos 0.1 segundos frente a los 0.5 segundos normales), significa que esa consulta probablemente ya estaba guardada en la memoria.

Esta falla de seguridad permitiría a los atacantes descubrir datos empresariales secretos, información personal y consultas privadas de otros usuarios.

El estudio mostró diferencias claras en los tiempos de respuesta. Por ejemplo, en la API text-embedding-3-small de OpenAI, el tiempo medio para una respuesta de la memoria era de aproximadamente 0,1 segundos, mientras que las respuestas nuevas tardaban hasta 0,5 segundos.

Las pruebas estadísticas dieron resultados muy significativos, normalmente con valores por debajo de 10⁻⁸, lo que señala claramente que hay almacenamiento en caché. Los investigadores también vieron que, muchas veces, bastaba con repetir una consulta una sola vez para activar el almacenamiento.

Además, el estudio reveló información no conocida sobre la arquitectura del modelo text-embedding-3-small de OpenAI, descubriendo que es un transformer de solo decodificador, un detalle técnico que no era público.

Según el estudio, los investigadores informaron a las empresas en octubre de 2024, dándoles 60 días para arreglar los problemas antes de publicar sus hallazgos. Al menos cinco proveedores hicieron cambios, como desactivar la memoria compartida entre organizaciones y actualizar su documentación.

OpenAI, por ejemplo, ha corregido la falla en su API text-embedding-3-small tras ser avisados.

¿Quieres saber más? Únete a los canales oficiales de Facialix:

Cómo protegerte

Si usas APIs de IA para desarrollo o en tu trabajo diario, considera estas medidas:

- Comprueba si tu proveedor usa almacenamiento en caché y cómo lo gestiona (por usuario, por organización o global)

- Evita incluir datos sensibles en tus consultas cuando sea posible

- Busca alternativas con mejores políticas de privacidad si necesitas procesar información confidencial

¿Has notado alguna vez respuestas inusualmente rápidas al hacer consultas similares en sistemas de IA? ¿Qué otras medidas crees que deberían tomarse para proteger la privacidad de los usuarios?

Fuentes: arxiv.org